大数据是一个营销术语,涵盖了从搜索引擎,通过积分卡等追踪的杂货店购买模式等来源开始的数据挖掘的整个构想。在现代世界中,互联网有这么多数据源,如果没有处理和处理,比例尺经常会使其无法使用,那么任何一台服务器都需要花费大量的时间。输入Apache Hadoop

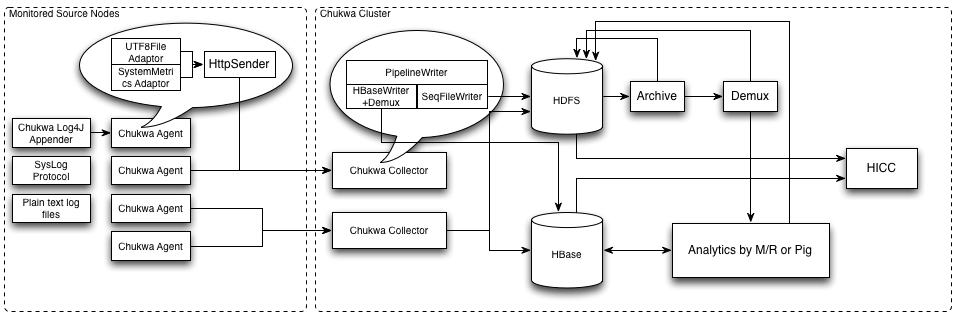

数据处理的时间更少通过利用Hadoop体系结构在网络中的多台计算机上分发处理任务,处理时间以天文数据的形式减少,可以在合理的时间内确定答案。 Apache Hadoop分为两个不同的组件:存储组件和处理组件。简而言之,Hapood使得多台物理机器中的一台虚拟服务器。实际上,Hadoop管理多台机器之间的通信,使它们之间的协作足够紧密,以至于看起来好像只有一台机器在计算上工作。数据分布在多台机器上以存储和处理任务由Hadoop架构分配和协调

。这种类型的系统需要将原始数据转换为大数据输入规模的有用信息。考虑用户输入搜索请求时每秒收到的数据量。作为数据总量,您不知道从哪里开始,但Hadoop会自动将数据集缩减为更小,有组织的数据子集,并将这些可管理子集分配给特定资源。然后将所有结果报告并汇编成可用信息。

易于设置的服务器虽然系统听起来很复杂,但大多数运动部件在抽象背后都是模糊的。 设置Hadoop服务器非常简单,只需将服务器组件安装在满足系统要求的硬件上即可。更难的部分是规划出计算机网络,Hadoop服务器将用来分配存储和处理角色。这可能涉及设置局域网或通过Internet连接多个网络。您还可以利用现有的云服务,并在流行的云平台(如Microsoft Azure和Amazon EC2)上支付Hadoop集群。这些更容易配置,因为您可以将它们自组织起来,然后在不再需要它们时停止使用它们。这些类型的集群非常适合测试,因为您只需支付Hadoop集群处于活动状态的时间。

处理您的数据以获取您需要的信息大数据是一种非常强大的资源,但除非数据可以正确分类并转换为信息,否则数据无用。目前,Hadoop 集群为处理这些数据集合成信息提供了一种极具成本效益的方法。

评论没有发现