有就是为何一个人或公司将要使用的网络爬虫软件,数之不尽。这种类型的程序浏览网络中可以实现自动化,系统化和有序的方式指定的方式。如果你是新来的名词网络爬虫软件,也许你听说过蜘蛛,机器人,蚂蚁,自动索引,机器人或scutters?他们都基本上是同样的事情!

网络爬虫软件的目的

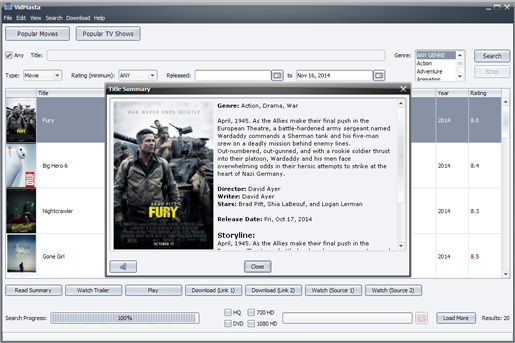

当你想到的网页抓取软件,你可能想象像谷歌,必应和雅虎的大牌搜索引擎。他们的机器人抓取通过网页来确定的内容,相关性和索引。通过创建访问过的网页的副本,它们可以提供更快速,更精确的搜索。 SqrBox会告诉你,你肯定不会需要一个搜索引擎都需要网络爬虫软件。你只需要有人谁的需要收集大量的或极复杂的信息。

网络爬虫软件类型

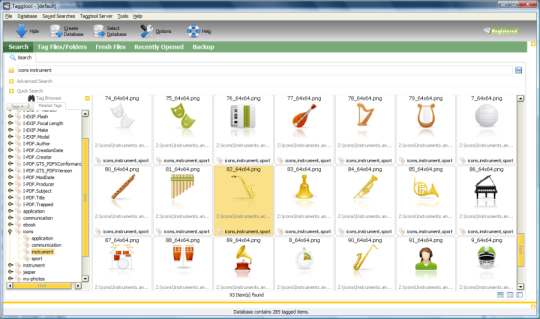

如果你打算使用专业公司的服务,如SqrBox,你并不真的需要与有关网络爬虫软件的所有复杂的行话关注。不过,这是有必要了解关于它的一些东西。

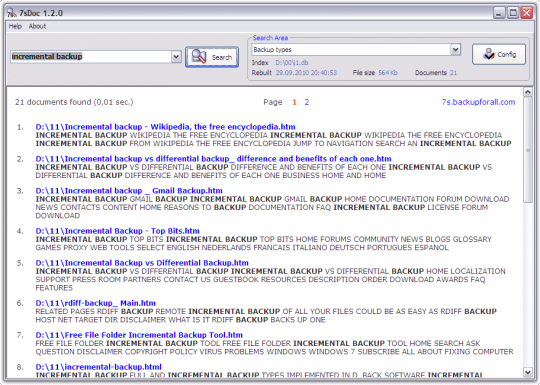

聚焦爬行 - 这种类型的网络爬虫软件的目的是要下载该看起来包含类似的信息的页面。经常有这种方法,虽然和履带式和结果的实际性能相关的一些瑕疵都依赖于这种链接是如何富人上被搜索的特定主题。这种类型的网络爬虫软件经常被用来作为起始点来缩小搜索进一步爬行。

网址规范化 - 网络爬行器软件将常常执行URL规范化的一定水平,这有助于减少在同一源不止一次的重复爬行。

限制其次链接 - 在某些情况下,网络爬虫软件可能希望避免某些网页内容,只寻求的.html页面。要做到这一点,URL往往审核,再资源才会被要求如果有某些字符的URL,例如的.html,.asp的,名为.htm,.PHP,的.aspx,.jspx或.JSP。网络爬虫软件通常会忽略的资源用“?”为了避免蜘蛛陷阱

要求:

.NET Framework 3.5的

评论没有发现